Индексация сайта в поисковых системах — как быстрее индексировать сайт?

Существует несколько способов определить, проиндексирована ли страница поисковыми системами. Ресурс AdButton о них расскажет.

Во время индексации происходит добавление роботом сведений о веб-странице в свою базу. После этого поиск проходит по страницам, которые прошли индексацию. Время сканирования поисковиком ресурса зависит в основном от робота.

Просмотреть, проиндексирована ли нужная страница, с помощью панели вебмастера

Первый вариант — от компании Google

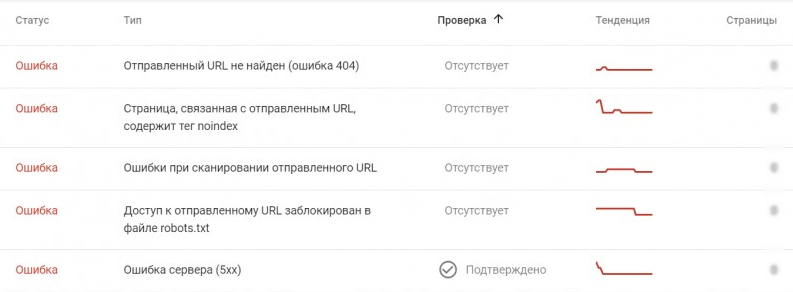

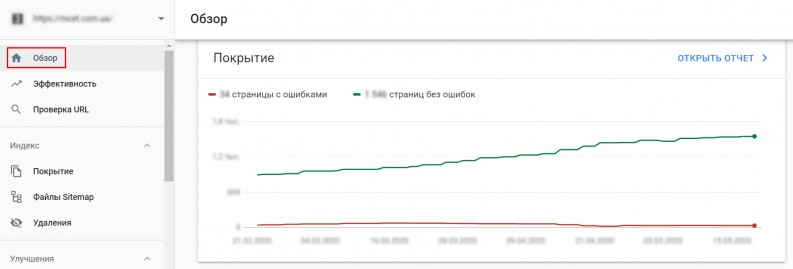

Нужно воспользоваться сервисом Search Console и, перейдя в «Обзор», зайти в «Покрытие»:

Зелёная линия графика — число вебстраниц, на которых отсутствуют ошибки индексации сайта, красная — страницы с ошибками. Если нажать на «Покрытие», то будет доступен детальный отчёт.

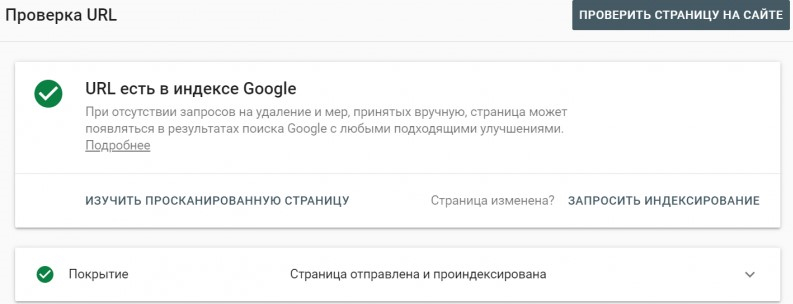

Существует возможность проверить и отдельную страницу. Чтобы это сделать, нужно указать её URL в поиске. В том случае, если ошибок нет, появится такое окно:

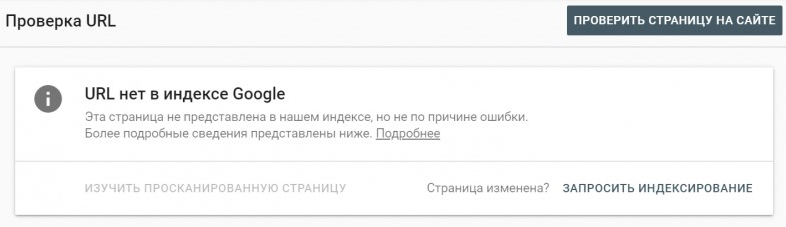

В случае, если контекстная страница не находится в индексе поисковых систем, появится следующее сообщение:

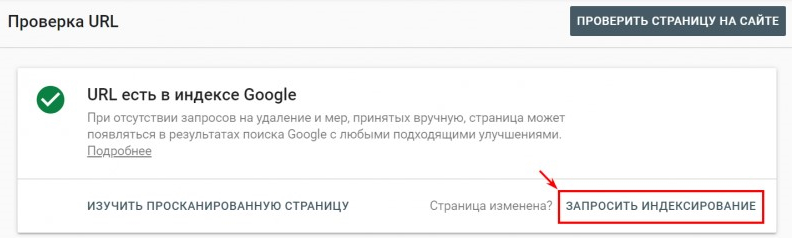

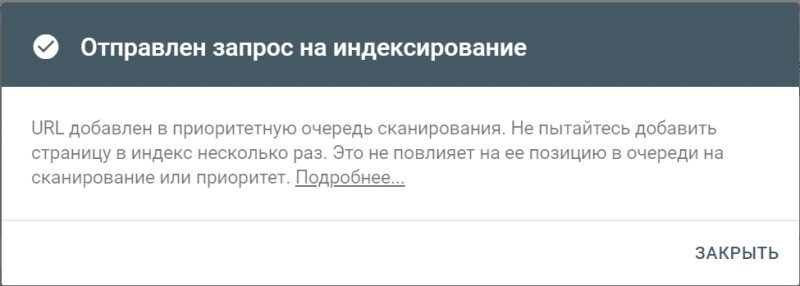

В том случае, если страница без индексации была изменена, можно нажать «запросить индексирование».

Если кнопка была нажата, выскочит следующее окно:

Способ для Яндекса

Авторизовываемся в сервисе Яндекс Паспорт, далее входим в Яндекс Вебмастер, соблюдая следующий путь: «Индексирование сайта» — «Страницы в поиске». В этом разделе показываются все изменения веб-страниц.

Для использования этого метода нужно иметь доступ в консоль для вебмастера. На картинке показан пример качественной индексации сайта.

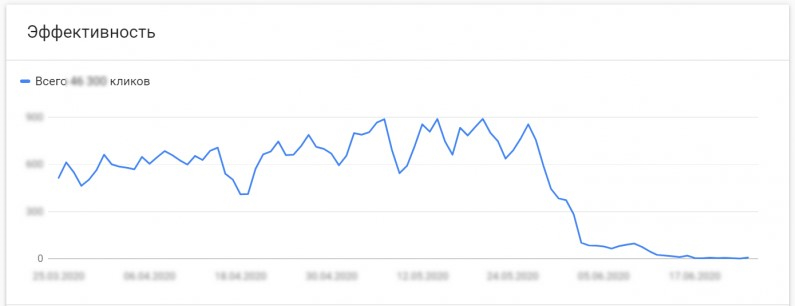

Плохое индексирование выглядит так:

Использование операторов поисковых запросов

Они предоставляют возможность уточнить результаты поискового запроса. Оператор <site:> предоставляет приблизительные сведения об индексированных страницах. Для того, чтобы их получить, в поисковике введите <site:[url вашего сайта]>. Благодаря дополнительным инструментам поисковиков возможно узнать примерное число индексированных веб-страниц.

Использование специальных плагинов и букмарклетов

Плагины и букмарклеты (простые js-утилиты, которые сохраняются в виде браузерных закладок) — автоматизированный способ. При их использовании не нужно что-то вводить самостоятельно.

Другой плагин — Seo Magic — выполняет ту же самую функцию: показывает количество проиндексированных страниц и может открыть их выдачу в поиске. У этого плагина есть ещё несколько полезных применений.

Причины ошибок индексации:

- Веб-ресурс создан недавно. Если это так, то стоит подождать, пока роботы выполнят свою работу.

- Отсутствие карты сайта. Правильно сделанная страница или файл sitemap позволит быстрее индексировать сайт в поисковых системах. Ссылку на sitemap следует добавить в консоль веб мастеров, а также в файл <robots.txt>.

- Ошибки в самом сайте. Нужно найти ошибки, которые обозначил робот при индексации, и исправить их.

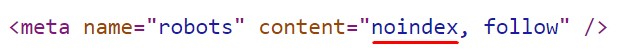

- Проблема с метатегом <robots>. Часто возникает при случайном изменении каких-либо параметров, например, параметров хостинга или CMS. В коде сайта всплывает такая строка:

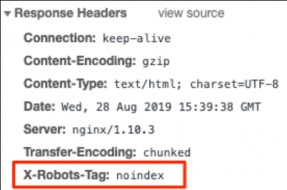

- Проблема с <X-Robot-Tag>. <X-Robots-Tag> — HTTP-заголовок, его разница с <robots> состоит в том, что он находится в файле сервера. Посмотреть закрытие ресурса в <X-Robots-Tag> можно, зайдя в консоль:

- Проблема с <robots.txt>. Мастера зачастую рекомендуют закрывать от индексирования в файле <robots.txt> то, что не должно индексироваться. Однако всего лишь один лишний символ может закрыть нужную страницу для индексации. Даже если всё сделано правильно, есть вероятность, что что-то зацепили. Если выдаёт это сообщение, значит, сайт является закрытым для индексации: <User-agent: * Disallow: />.

Проблемы с индексированием могут возникнуть из-за:

- многократное дублирования страниц;

- неоригинальное содержания страницы;

- проблемы со скоростью загрузки сайта.

Уменьшение длительности индексации

Число проверенных веб-страниц зависит от бюджета. Но, конечно же, лучше всего, если новая информация попадёт в выдачу поисковика как можно быстрее, у вас получится улучшить монетизацию сайтов и привлечь новых посетителей.

Конечно же, всегда возможно отправить одну или несколько страниц на принудительную индексацию, но есть ещё несколько способов.

Обновление карты сайта

Абсолютно все новые страницы должны указываться в карте сайта. С помощью этого файла поисковики могут определить структуру сайта, лучше ориентируются в нём. Дополнительно возможно повысить приоритетность индексации некоторых страниц.

Как справиться с дублированием веб-страниц

Избавление от дублирующихся веб-страниц и создание оригинального содержания очень важно. Во время проверки робот расходует на дублированные страницы и неоригинальное содержание весь свой краулинговый бюджет. В итоге, необходимые для продвижения сайта странички остаются без индексации. Стоит контролировать появление этих двух врагов индексации, чтобы не слить бюджет.

Бороться с битыми ссылками стоит путём контроля их качества и контроля правильности редиректов.

Редиректы и неиспользующиеся страницы тратят краулинговый бюджет. Внутренние редиректы, скорее всего, приведут к тому, что робот посетит одну страницу несколько раз, что израсходует краулинговый бюджет. Стоит следить за отсутствием таких проблем:

- Грамотная настройка <robots.txt>. Роботы берут во внимание этот файл, но не чётко следуют ему. Совет: грамотно настроить файл.

- Уменьшение времени ответа сервера.

- Увеличение скорости загрузки веб страниц. Любой пользователь, заходя на сайт, сталкивается с загрузкой. Если она долгая, то пользователь уйдёт и монетизация сайта не состоится. Длительность загрузки веб страницы не должна превышать трёх-четырёх секунд, а длительность ответа сервера — не более 200 мс. Сервис Page Speed Insights поможет улучшить скорость загрузки сайта. Для этого нужно лишь следовать его инструкциям.

- Правильная перелинковка сайта. Грамотная перелинковка способна уменьшить нагрузку на страницы и увеличить монетизацию сайта путём увеличения времени, которое пользователь проводит на сайте. Робот способен переходить по ссылкам в тексте, так что стоит их использовать, ведь благодаря этому улучшается качество сайта.

- Размещение карточек элементов на главной. Это поможет быстрее заметить новый товар как живым пользователям, так и роботам.

- Публикация ссылок в соцсетях. Вполне возможно, что с помощью ссылки на веб-сайт, рекламируемой в соцсети, увеличится поток посетителей, что для робота является сигналом к началу индексирования.

Об обновлении веб-сайта

Поисковики любят постоянно обновляющиеся сайты. Вне всяких сомнений, стоит потратить своё время ради грамотной индексации, поэтому, публикуйте новую информацию на сайте как можно чаще, неактуальную информацию удаляйте, следите за её актуальностью, оптимизируйте следующие заголовки: <Last-Modified>, <If-Modified-Since>, <Etag>, <If-None-Match>.

Важно!

Сложно достигаемая цель любого владельца сайта — добиться индексирования всех необходимых страниц. Следует контролировать внесение в индекс поисковика новых страниц, потому что это поможет монетизировать сайт и заработать на рекламе в интернете.